Au cours des dernières décennies, l’informatique classique a transformé notre manière de vivre et de travailler. Il a permis l’émergence d’Internet et des services numériques qui ont remodelé les interactions humaines, le commerce ou encore l’éducation.

En 2023, la puissance combinée des data centers mondiaux atteignait 100 zettaflops (100 millions de milliards d’opérations par seconde), afin de soutenir les milliards d’utilisateurs connectés chaque jour.

Mais pour mieux comprendre comment l’informatique est devenue une force motrice de nos sociétés modernes, il convient de rappeler les origines de cette transformation.

Les débuts de l’ère de l’informatique

La création des premiers ordinateurs, tels que l’ENIAC (Electronic Numerical Integrator and Computer) en 1946, marqua le point de départ d’une nouvelle ère technologique. Ces machines, bien que rudimentaires par rapport à nos standards actuels, permirent de réaliser des calculs complexes qui étaient auparavant hors de portée de l’esprit humain ou des outils mécaniques. John von Neumann, un des pionniers de l’informatique moderne, développa l’architecture fondamentale qui est encore au cœur de nos ordinateurs contemporains.

Durant les décennies suivantes, les progrès furent exponentiels. Les transistors, introduits en 1947, remplacèrent les tubes à vide, rendant les ordinateurs plus petits, plus rapides et plus fiables. Dans les années 1970, les microprocesseurs donnèrent naissance à l’informatique personnelle, intégrant toutes les fonctions essentielles d’un processeur sur une seule puce de silicium. Cette miniaturisation permit de rendre les ordinateurs accessibles à un plus large public.

Cependant, cette évolution impressionnante arrive aujourd’hui à ses limites. Les lois de la physique classique qui gouvernent les transistors ne permettent plus d’augmenter indéfiniment la puissance de calcul. C’est dans ce contexte que l’informatique quantique émerge comme une nouvelle frontière.

L’informatique quantique : une révolution en gestation

L’informatique quantique trouve ses racines dans les années 1980, lorsque Richard Feynman et David Deutsch posèrent les bases théoriques de machines exploitant les principes de la mécanique quantique. Ces idées furent renforcées en 1994 avec l’algorithme de Shor, qui démontra la capacité théorique des ordinateurs quantiques à factoriser de grands nombres de manière exponentiellement plus rapide que les ordinateurs classiques, mettant en évidence leur potentiel en cryptographie.

Les premiers prototypes d’ordinateurs quantiques apparurent dans les années 2000, grâce aux efforts conjugués d’institutions académiques et d’entreprises comme IBM, Google et D-Wave. En 2019, Google annonça même avoir atteint la « suprématie quantique » avec son processeur Sycamore, capable de réaliser en 200 secondes un calcul qu’un supercalculateur classique aurait mis 10 000 ans à effectuer.

Fonctionnement des ordinateurs quantiques

Contrairement aux ordinateurs classiques, qui utilisent des bits binaires (0 ou 1), les ordinateurs quantiques exploitent des qubits, ou bits quantiques. Grâce au principe de superposition quantique, les qubits peuvent représenter simultanément les états 0, 1 ou une combinaison des deux. Cette propriété leur permet de traiter plusieurs états en parallèle.

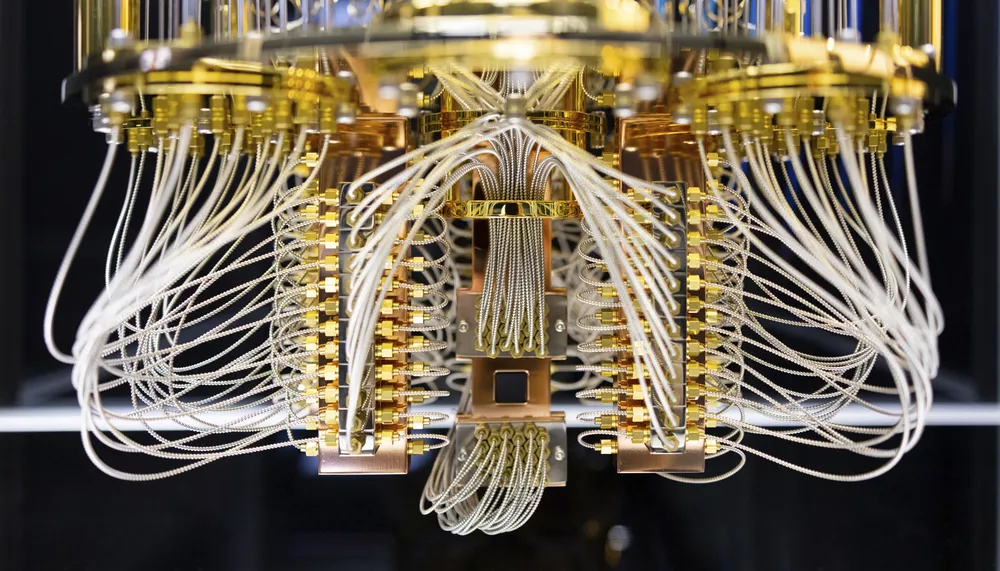

En général, les qubits sont créés en manipulant et en mesurant des particules quantum (les plus petits éléments constitutifs connus de l’univers physique), telles que des photons, des électrons ou des atomes. Pour manipuler ces particules, les qubits doivent être maintenus extrêmement froids afin de minimiser le bruit et d’éviter qu’ils ne fournissent des résultats inexacts ou des erreurs résultant d’une décohérence involontaire.

Lors du traitement d’un problème complexe, tel que la factorisation d’un grand nombre, les bits traditionnels sont bloqués par les grandes quantités d’informations qu’ils contiennent. Étant donné que les qubits peuvent contenir une superposition, un ordinateur quantique qui utilise des qubits peut aborder le problème d’une manière différente des ordinateurs classiques.

Imaginez que nous devions trouver une combinaison de coffre à plusieurs chiffres, sans connaître le code. Avec un ordinateur classique, nous serions contraint d’essayer chaque combinaison une par une jusqu’à tomber sur la bonne, un processus qui deviendrait extrêmement long si le nombre de chiffres était élevé. Chaque tentative serait comme un bit qui enregistre si une combinaison fonctionne ou non.

En revanche, un ordinateur quantique aborde ce problème différemment : les qubits, grâce à leur capacité de superposition, peuvent représenter simultanément toutes les combinaisons possibles. Plutôt que de tester chaque combinaison séparément, l’ordinateur quantique peut exploiter des algorithmes spécifiques (comme l’algorithme de Shor) pour amplifier les probabilités des bonnes solutions et minimiser celles des mauvaises.

Le processus est comparable à une lumière passant à travers un prisme. Au départ, la lumière blanche contient toutes les couleurs (ou toutes les solutions possibles). Lorsqu’elle passe par un prisme (ici l’algorithme quantique), seules certaines couleurs sont amplifiées et deviennent visibles (les solutions correctes), tandis que les autres s’annulent. Ainsi, l’ordinateur quantique identifie la bonne combinaison bien plus rapidement qu’un ordinateur classique.

Ce fonctionnement unique des qubits permet non seulement de résoudre ce type de problème de manière beaucoup plus efficace, mais aussi d’ouvrir des perspectives impossibles avec les approches classiques.

Le problème de la décohérence quantique

Pour exécuter des calculs complexes bien plus rapidement, l’ordinateur quantique nécessite un grand nombre de qubits, hors plus le nombre de qubits augmente, plus ceux-ci deviennent instables, créant un phénomène qui peut interrompre les calculs avant leur achèvement. Les qubits sont en effet extrêmement fragiles et difficiles à stabiliser.

La décohérence quantique correspond à la perte des propriétés quantiques des qubits, telles que la superposition ou l’intrication (plusieurs qubits peuvent être liés de manière telle que l’état de l’un affecte instantanément l’état de l’autre), en raison de leurs interactions avec l’environnement. Ce phénomène entraîne une transition du comportement quantique des qubits vers un comportement classique, annulant ainsi les avantages spécifiques que l’ordinateur quantique peut offrir.

Plusieurs facteurs peuvent être à l’origine de cette décohérence :

- Bruit thermique : Les vibrations des atomes dues à la chaleur perturbent l’état des qubits. Ces fluctuations thermiques constituent un défi majeur, en particulier pour les systèmes quantiques qui fonctionnent à température ambiante ou légèrement au-dessus du zéro absolu.

- Couplage avec l’environnement : Les qubits ne sont jamais complètement isolés de leur environnement. Les interactions involontaires avec des particules comme des atomes, des photons ou d’autres éléments du système, modifient leurs états quantiques. Par exemple, une particule environnante pourrait détruire l’intrication ou altérer la superposition d’un qubit en échangeant de l’énergie ou de l’information avec lui. Ce couplage parasite représente une fuite d’information quantique connue sous le nom de « décohérence environnementale ».

- Imprécisions dans les contrôles : La manipulation des qubits repose sur des techniques de précision extrême, telles que des impulsions laser ou micro-ondes soigneusement calibrées. Cependant, des erreurs peuvent se produire, comme des durées d’impulsion incorrectes, des angles de rotation imprécis ou des fréquences légèrement décalées. Ces imprécisions, souvent liées aux limitations des instruments ou à la variabilité des composants, peuvent perturber les états quantiques des qubits et accélérer leur décohérence.

En raison de ces problèmes, un ordinateur quantique doit être bien isolé du monde extérieur, ce qui nécessite des systèmes simples et très froids, à l’écart de toute nuisance. Ce confinement crée cependant une situation paradoxale, car plus l’ordinateur est isolé, plus il est difficile de communiquer avec lui (pour accéder aux résultats de ses calculs par exemple, ou de contrôler ce qu’il fait).

Ordinateur quantique et IA : des synergies prometteuses

L’intelligence artificielle repose principalement sur des algorithmes capables d’apprendre, de prédire et d’analyser des données. Les techniques d’apprentissage machine exigent une puissance de calcul considérable, en particulier lorsqu’on s’attaque à des ensembles de données complexes. Un exemple typique est le deep learning où un réseau de neurones doit optimiser des millions, voire des milliards de paramètres pour apprendre efficacement à partir de données. Cela prend du temps, des ressources énergétiques et nécessite des ordinateurs hautement performants.

Les ordinateurs quantiques peuvent simuler des modèles complexes qui sont hors de portée des machines actuelles. Hors, l’une des grandes difficultés des systèmes d’IA réside dans l’entraînement des modèles d’apprentissage sur des données gigantesques. Aujourd’hui, avec des modèles comme GPT-4 ou des architectures comme Transformer, le temps nécessaire pour entraîner un modèle sur des superordinateurs peut prendre des semaines ou des mois. Les ordinateurs quantiques, en tirant parti de la superposition, pourraient entraîner de tels modèles de manière parallèle et simultanée et réduire drastiquement les temps d’apprentissage.

Dans le domaine de la finance par exemple, les systèmes d’IA analysent actuellement des comportements complexes de marché pour prévoir des tendances boursières. L’ajout d’algorithmes quantiques permettrait d’explorer toutes les possibilités de prédiction et d’améliorer significativement les rendements des modèles, en prenant en compte des corrélations non linéaires extrêmement complexes, invisibles pour un ordinateur traditionnel.

D’ici les prochaines décennies, la convergence entre IA et ordinateur quantique pourrait conduire à des percées inimaginables dans plusieurs secteurs :

- Médecine et biologie : Actuellement, la recherche de nouvelles molécules thérapeutiques repose sur des simulations complexes réalisées par des supercalculateurs. Devant l’immensité des combinaisons moléculaires possibles, l’ordinateur quantique pourra analyser simultanément un grand nombre de configurations et prédire leur efficacité dans des temps extrêmement réduits.

- Sécurité et cryptographie : Grâce à des algorithmes comme celui de Shor, les ordinateurs quantiques sont capables de casser les systèmes cryptographiques actuels en un temps record. Les algorithmes traditionnels de chiffrement deviendront bientôt obsolètes face aux capacités de calcul quantique. Cependant, l’intelligence artificielle combinée au quantique pourrait transformer cette menace en opportunité. Les systèmes d’IA pourront être utilisés pour concevoir des protocoles de cryptographie quantique qui seront résistants à toute tentative de piratage.

- Énergies renouvelables et climat : Grâce à des modèles prédictifs plus rapides et plus précis, l’IA quantique pourra optimiser la consommation énergétique mondiale et simuler des scénarios de changements climatiques. Par exemple, pour prédire l’évolution du climat global, il faudrait modéliser l’interaction complexe entre des milliers de variables comme la température, l’humidité, la pression atmosphérique et l’activité humaine. Les ordinateurs quantiques, associés à des modèles d’IA avancés, pourraient simuler ces interactions avec une précision inégalée.

Par ailleurs, l’IA pourrait servir de chef d’orchestre pour les ordinateurs quantiques, en identifiant les problèmes les mieux adaptés au calcul quantique, tout en simplifiant leur utilisation grâce à des interfaces intelligentes.

L’ordinateur quantique à travers le monde

L’essor des technologies a déclenché une véritable course mondiale où entreprises et gouvernements rivalisent d’ingéniosité pour conquérir la suprématie quantique. Cette compétition effrénée, motivée par des enjeux stratégiques, économiques et scientifiques, repousse continuellement les limites de l’innovation :

Tianyan-504 de Chine

En décembre 2024, la Chine a dévoilé Tianyan-504, un ordinateur quantique doté d’une puissance de calcul inédite pour le pays. Cette machine s’appuie sur une puce supraconductrice baptisée Xiaohong-504, capable de gérer 504 bits quantiques.

Si la Chine affiche clairement son ambition de se hisser au sommet de la hiérarchie mondiale en matière d’informatique quantique, Tianyan-504 ne se limite pas à une course effrénée aux qubits. Ce projet vise avant tout à bâtir une infrastructure solide pour les systèmes quantiques à grande échelle, en mettant l’accent sur le développement d’un écosystème complet.

Osprey d’IBM

IBM a présenté en novembre 2022 son processeur quantique “Osprey”, intégrant 433 qubits, soit le triple de la génération précédente, “Eagle”.

Cette augmentation significative du nombre de qubits rapproche IBM de son objectif de développer des systèmes quantiques de plus de 1 000 qubits, avec des ambitions affichées pour des systèmes de plusieurs dizaines de milliers de qubits à partir de 2026..

H2-1 de Quantinuum

Quantinuum a développé le H2-1, un ordinateur quantique de 56 qubits qui a surpassé les performances de la machine Sycamore de Google par un facteur de 100, tout en consommant 30 000 fois moins d’énergie.

Cette efficacité énergétique remarquable, combinée à des performances accrues, a démontré l’importance de l’optimisation des ressources dans le développement des technologies quantiques. Le H2-1 illustre comment une architecture bien conçue peut offrir des performances exceptionnelles sans nécessiter un nombre exorbitant de qubits.

Willow, la puce quantique de Google

Dernière révolution en date, Willow, la puce quantique de Google, revendique 105 qubits sur base de supraconducteurs (le double de sa précédente puce Sycamore), et se distingue notamment pour son système avancé de correction d’erreurs. En effet, les qubits supraconducteurs sont extrêmement sensibles aux interactions avec leur environnement, et généralement, l’augmentation du nombre de qubits accentue ces erreurs.

Toutefois, Willow semble inverser cette tendance. Hartmut Neven, directeur de Google Quantum AI, explique : « Nous avons testé des réseaux de qubits physiques de plus en plus grands, passant d’une grille de 3×3 qubits encodés à une grille de 5×5, puis à une grille de 7×7. À chaque étape, nos avancées en correction d’erreurs quantiques ont permis de réduire le taux d’erreur de moitié. »

Mais Willow n’est pas seulement douée pour corriger les erreurs, elle est également très puissante. Elle a en effet réalisé un calcul de référence standard en moins de cinq minutes, qui aurait pris à l’un des supercalculateurs les plus rapides d’aujourd’hui 10 septillions d’années (soit dix milliards de milliards de milliards d’années) !

Une quête technologique et philosophique

L’informatique quantique, par sa nature même, nous invite à repenser notre rapport au réel, à l’infiniment petit et à la complexité du monde. Là où l’informatique classique a permis de domestiquer les calculs et d’organiser la masse d’informations qui nous submerge, le quantique ouvre une fenêtre sur l’inconnu, un territoire où les lois de la physique classique cèdent la place à un univers de superpositions et d’incertitudes.

Ce n’est plus seulement une question de puissance ou de vitesse, mais d’explorer des dimensions de la réalité jusqu’ici inaccessibles, d’appréhender des problèmes qui, par leur nature même, défient notre intuition et nos limites cognitives.

À travers ces machines fragiles et sophistiquées, nous touchons du doigt la frontière entre le connu et l’inconnu, entre ce qui est et ce qui pourrait être. Cette quête technologique pourrait presque résonner comme une quête philosophique : comprendre, prévoir, et peut-être même maîtriser les mystères de l’univers.

La question reste ouverte : jusqu’où cette exploration nous mènera-t-elle, et qu’allons-nous y découvrir sur nous-mêmes ?